Introducción: La sociedad del conocimiento y la inteligencia artificial

El potencial de disrupción de la inteligencia artificial y su evolución vaticina que su desarrollo acentuará su impacto en materia socioeconómica, laboral y política. Si bien es una técnica largamente conocida en el ambiente de las ciencias de la computación, fue potenciada por el crecimiento de la capacidad de cálculo y la masividad de las redes de datos. Su aparición invisible y silenciosa en nuestra vida cotidiana no tiene vuelta atrás, obliga a los individuos a un enorme esfuerzo de adaptación. Y a la sociedad toda, a gestionar este desafío que podría equipararse a la irrupción de la energía nuclear, en tanto y en cuanto a la brecha tecnológica que genera. Para la necesaria protección de las personas y de los Estados que no logren adaptarse con la suficiente velocidad, se deberán generar mecanismos de regulación que mitiguen los riesgos y peligros asociados, así como potenciar sus beneficios. En este número, Oscar Oszlak ilumina estos aspectos con su artículo “Impacto de la inteligencia artificial en la gestión estatal”.

Pero volviendo a los orígenes cercanos, hace dos siglos, la matemática británica Ada Byron de Lovelace (1815-1851), autora del primer algoritmo destinado a ser procesado por una máquina –la computadora mecánica de Charles Babbage–, postuló que “las máquinas solo hacen aquello que les ordenamos que hagan”. Quizás uno de los corolarios del principio de Ada sería la tesis GIGO (“si entra basura, sale basura”), con lo cual el programador es el principal responsable. Durante el siglo pasado, a pocos años de la creación de la primera computadora electrónica (ENIAC 1945), Alan Turing en su obra Computing Machinery and Intelligence (1950) vuelve a interrogarse si las máquinas pueden pensar y estableció una prueba para distinguir si una computadora es o no inteligente. Para esto ideó un escenario donde una persona realice una consulta, sin contacto físico, y de la respuesta no se pueda discernir si quien responde es una máquina o una persona. Actualmente lo conocemos como CAPTCHA –“completely automated public Turing test to tell computers and humans apart”– y es parte de nuestra rutina para acceder a ciertos portales que desean protegerse de intrusiones de bots –robots de software–. Muchos sostienen que el test de Turing ha sido superado, desde el momento en que la inteligencia artificial ha alcanzado un nivel que torna cada vez más difícil saber si se está interactuando con una máquina o una persona.

El concepto de inteligencia artificial (IA) se debe al informático estadounidense John McCarthy, quien en el año 1956 lo pronunció por primera vez en una conferencia causando un gran impacto en el ámbito de la tecnología. A partir de entonces, el concepto se diseminó fantásticamente por el mundo y por ello hoy es tan común su uso cuando queremos referirnos a aquellas máquinas o aparatos dotados de una inteligencia símil a la de los seres humanos.

Muy tempranamente, en 1957, durante una conferencia Herbert Simon (premio Nobel de Economía 1978, por sus trabajos en la Teoría de las Decisiones) afirmó: “Sin afán de sorprenderlos y dejarlos atónitos, debo informarles lisa y llanamente que actualmente en el mundo existen máquinas capaces de pensar, aprender y crear. Además, su capacidad para hacer lo anterior aumentará rápidamente hasta que en un futuro previsible la magnitud de problemas que tendrán capacidad de manejar irá a la par con la capacidad de la mente humana para hacer lo mismo”.

Para rebatir a Simon, John Searle (1980) en su texto de “Mentes, cerebros y ciencia” ataca este pensamiento con el experimento mental de la Habitación China. En él muestra cómo una máquina puede realizar una acción sin siquiera entender lo que hace ni por qué lo hace. Por lo tanto, según Searle la lógica usada por las computadoras es nada más que un mecanismo que no busca el sentido en la acción, como la usada por los seres humanos. No tiene un “para qué”. Este enfoque puede ser descrito en términos del llamado “Juego de la Imitación” que traslada el peso de la respuesta desde la esencia (ser o no ser) a la apariencia (como si). En palabras de Searle, “la gramática y la sintaxis solas no son suficientes para la semántica y las computadoras digitales en tanto máquinas tienen, por definición, solamente gramática y sintaxis”. Amén.

Estos planteos filosóficos dieron origen a dos vertientes, los defensores de la inteligencia artificial “fuerte” que creen que es posible crear “inteligencia de verdad” y los pragmáticos que se enfocan en los resultados y piensan que cuantas más personas se puedan engañar creyendo que en las tripas de la máquina existe la inteligencia, entonces el truco es lucrativo. Ramiro Verrastro nos enseña algunos de estos trucos en su artículo sobre “Técnicas de la inteligencia artificial”.

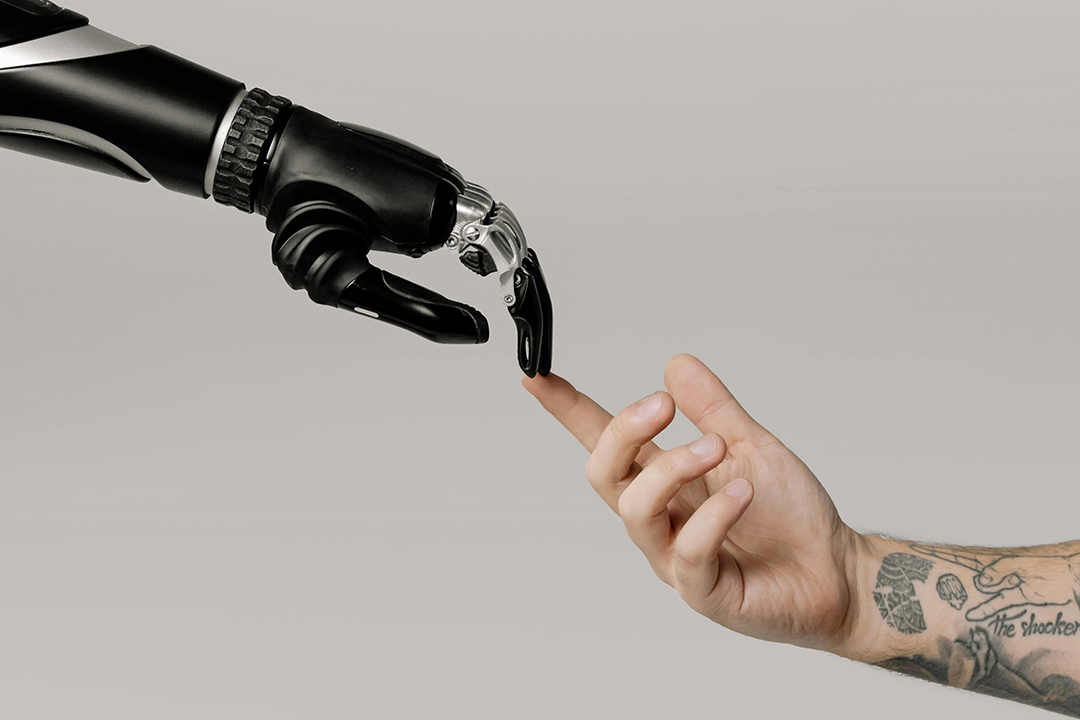

Una característica saliente del ser humano es potenciar sus propias fuerzas mediante la utilización de herramientas y la apropiación de los recursos naturales para sus propios fines, como la utilización de la fuerza de los animales para labrar la tierra, transporte, etc., la máquina de vapor para la utilización del carbón, los motores de explosión para la utilización del petróleo, la energía nuclear para generar electricidad. En cambio, la IA permite potenciar las fuerzas del intelecto humano para mejorar la búsqueda, la representación y el almacenamiento de conocimiento y generar nuevo conocimiento explorando posibles soluciones a problemas que sin la utilización de estas técnicas serían inabordables.

Básicamente la IA es un soporte para las actividades del intelecto humano que de alguna manera hace que las personas puedan tener una mejor comprensión del mundo y de sí mismas. Se la puede pensar como una tecnología que colabora en la fabricación de herramientas cada vez más útiles en la producción de bienes y servicios.

Una de estas herramientas son las “Redes neuronales artificiales” (RNA), Ramiro Rodríguez Colmeiro en su artículo nos cuenta sobre el potencial de las RNA a partir de su desarrollo explosivo desde principios de este siglo, con la posibilidad del procesamiento masivo de datos o Big Data y el desarrollo de varias arquitecturas de aprendizaje profundo como las redes neuronales profundas, convolucionales así como generativas, se aplican a campos como la visión artificial, reconocimiento automático del habla y reconocimiento de imágenes, señales de audio y música que mostraron resultados de vanguardia en varios campos.

Tal como Martin Belzunce en su artículo “Cómo la inteligencia artificial está revolucionando las imágenes médicas: aplicaciones, riesgos y desafíos” nos ilustra sobre aplicaciones en salud humana.

También la IA mejora la interacción entre los hombres y las máquinas, haciéndolas más fácil de usar y más productivas. Actualmente los desarrollos están orientados a robots que puedan desenvolverse junto a las personas para prestarles asistencia. Ejemplos de ello son el proyecto Roboy para realizar tarea de servicios, desde camareros hasta asistentes geriátricos, guías de museo, etc., la tecnología para asistencia a la conducción de vehículos (ADAS) y para la disminución de accidentes viales. Ariel Hernández en su artículo “Autonomía en movimiento: perspectivas y desafíos de los vehículos autónomos” nos ayuda a comprender los retos que enfrentan las aplicaciones de IA en entornos no estructurados donde deben interactuar con personas.

En la industria, los robots son cada vez más automáticos y pueden realizar tareas más sofisticadas, los sistemas de visión permiten tomar decisiones en máquinas clasificadoras y de control de calidad, para la optimización de la utilización de materias primas y disminución de descartes. En el ámbito científico los programas de simulación y de cálculo permiten predecir cambios climáticos y el impacto de las acciones humanas, permiten desarrollar sistemas para economizar recursos naturales y explorar alternativas que con las herramientas de cómputo tradicionales son inviables. Jorge Bauer en su trabajo “Autonomación, automatización, inteligencia artificial e industria-agricultura 5.0 en la producción agroecológica sostenible de alimentos” nos permite avizorar que la integración de las herramientas de IA con otras tecnologías habilita otras formas de producción menos invasivas y más sostenibles desde el punto de vista ambiental.

La IA es una herramienta, independientemente de su poder. Como toda herramienta, el hombre puede decidir usarla como un arma de destrucción de sus semejantes o para construir una sociedad mejor. Eso ocurrió desde el garrote que pudo y puede usarse como un martillo hasta con la energía atómica que pudo y puede usarse como una bomba o como combustible de una central nucleoeléctrica. Hiroshima es testigo de que cuanto más poderosa es la herramienta, más daño puede causar cuando se la usa como un arma. Leandro Di Matteo en su artículo “Armas letales autónomas e inteligencia artificial” nos advierte que las “armas asesinas” o AKM (del inglés, automated killing machines) ya saltaron de la pantalla a la vida real.

Efectivamente la tecnología ya alcanzó el grado de madurez necesario para ser usada en forma autónoma, sobre todo cuando los daños “colaterales” los paga el “otro”. Al respecto, la reunión internacional realizada en Buenos Aires en 2015 se utilizó para lanzar una carta abierta firmada por miles de investigadores de IA y robótica, que denomina públicamente a la IA como la “mayor amenaza existencial de la humanidad”. Según los expertos, la creación de las máquinas asesinas es una “tercera revolución en la guerra”, después de la pólvora y las armas nucleares. “Cuando se abra la caja de Pandora, será difícil cerrarla”, advirtieron en el encuentro.

Aquella cita del 2015 ayudó a empujar a la ONU a realizar las primeras conversaciones formales sobre el creciente universo de la robótica y la IA y sus aplicaciones bélicas. También contribuyó a crear conciencia de las posibles consecuencias irremediables que pueden provocar. A fines de 2017, un grupo de 116 ejecutivos de 26 empresas dedicadas al desarrollo de IA –entre ellos el inventor y millonario sudafricano Elon Musk– firmaron en Melbourne (Australia) una carta abierta dirigida a las Naciones Unidas solicitando la prohibición de las Máquinas de Matar Autónomas. No es el primero ni único llamado que se realiza al Organismo de Naciones Unidas, donde se creó un grupo expertos específico que actúa dentro de la Convención sobre Ciertas Armas Convencionales (The Convention on Certain Conventional Weapons –CCW–), Organismo de United Nations. Office for Disarmament Affairs UNODA. Esta convención sobre prohibiciones o restricciones del empleo de armas que puedan considerarse excesivamente nocivas o de efectos indiscriminados y sus protocolos sobre LAWS (Lethal Autonomous Weapon Systems, sistemas de armas letales autónomas) produjo reuniones y definiciones desde 2013 que pueden consultarse en https://docs-library.unoda.org/Convention_on_Certain_Conventional_Weapons_-Group_of_Governmental_Experts_on_Lethal_Autonomous_Weapons_Systems_(2023)/CCW_GGE1_2023_CRP.1_0.pdf.

¿Quién decide cuando el uso de un arma es responsable? Hay una preocupación mayoritaria de que el arma se vuelva en contra del que la usa. Es como si se protegiera al agresor y no al agredido. Las aplicaciones potencialmente peligrosas no se limitan a las AKMs, pueden estar ocultas en los robots de búsqueda y clasificación de información, que pueden acceder a la información en forma global, pero también pueden entregar información sobre nosotros mismos a usuarios no autorizados o maliciosos, Leonardo Servalli nos advierte en su trabajo “Desafíos de ciberseguridad en la inteligencia artificial” de los riesgos cada vez mayores sobre la privacidad de los datos sensibles que pueden cubrir un amplísimo espectro, desde datos bancarios hasta los aspectos personales, familiares y laborales.

A la par de las herramientas tradicionales para proteger los datos como la encriptación también están amenazadas por otra tecnología emergente, la computación cuántica, que puede potenciar aún más las aplicaciones virtuosas y por supuesto también las maliciosas. Martin Kuffer nos cuenta sobre este tema en “Todo lo que quisiste saber sobre computación cuántica y nunca te animaste a preguntar”.

Los avances en la tecnología y las comunicaciones se traducen en avances en el sistema económico, el sistema político, la distribución de bienes, la desigualdad social y otros aspectos de la vida social. Pilar Fajarnes nos propone en su trabajo “Digitalización para un desarrollo inclusivo” que la tecnología no es determinista, los beneficios no se crean de manera automática y que, sin la intervención pública, es muy posible que las desigualdades asociadas a la digitalización aumenten.

Es muy difícil predecir el futuro, inclusive genios como Asimov o Alan Turing, por citar algunos conocidos, se equivocaron en sus predicciones. Los programas de simulación y modelado (muchos utilizan IA) predicen que el estilo de vida actual del hombre es insostenible por su impacto en la naturaleza y en el cambio climático. Flavia Costa y Julián Mónaco en el artículo “¿Pueden las humanidades coevolucionar con los humanos (y las máquinas)? Inteligencia artificial, sociedad artificial y los desafíos para las ciencias sociales”, plantean aspectos que ponen en riesgo a la sociedad, por la pérdida de credibilidad de las autoridades gubernamentales, así como de la información periodística ante la difusión masiva de noticas falsas –cada vez más sofisticadas– que son generadas mediante alteraciones de audio y video e influyen en una parte importante de nuestros modos de relacionarnos socialmente, dando lugar a una “Sociedad Artificial”. La IA y el ecosistema digital ya no sólo son herramientas sino un “mundoambiente” y las ciencias sociales se deberán reconvertir para poder cartografiar un territorio complejo y multicapa para viabilizar un “nuevo acuerdo tecnológico” para nuevas democracias digitales.

¿Podrá la sociedad adquirir la sabiduría necesaria para hacer el mejor uso de un saber con empatía y comprensión?

Autorxs

Claudio Verrastro:

Ingeniero Electrónico de la Universidad de Buenos Aires. Magíster en Software. Fue jefe de la División de Sistemas Digitales y Robótica de la Comisión Nacional de Energía Atómica (CNEA) y responsable del diseño y desarrollo de Tomografía por Emisión de Positrones y Sistema de Protección de Reactores para reactores nucleares. Se desempeñó como Profesor Asociado e Investigador Principal en Inteligencia Artificial y Robótica en la Universidad Tecnológica Nacional de Buenos Aires (UTN). Es Investigador Consulto de la CNEA y miembro del Consejo Asesor de la UTN FRBA.